سبد خرید شما خالی است.

91693461021

با ما در تماس باشـید

سبد خرید شما خالی است.

با ما در تماس باشـید

زمان مطالعه7 دقیقه

می پسنـدم0

اندازه متن12

در دو سال گذشته شاهد بودیم که چگونه مدلهای یادگیری عمیق انقلاب هوش مصنوعی را رقم زدند و طیف وسیعی از امکانات کاربردی را، از ابزارهای جدید جستوجو گرفته تا مولدهای تصویر، در دسترس ما گذاشتند؛ اما هرچه هم این مدلها را شگفتانگیز و کارآمد بدانیم، بازهم قدرت بالای آنها در به خاطر سپردن و تکرار دقیق دادههای آموزشی، به شمشیری دو لبه تبدیل شده و چالشهایی جدی را در این حوزهی نوظهور مطرح کرده است.

فراموشی ماشین (Machine Unlearning) میتواند به راهحلی مؤثر برای مشکل آموزش مدلهای هوش مصنوعی با دادههای نامطلوب، گمراهکننده یا آسیبزا تبدیل شود.

مدلهای هوش مصنوعی مانند GPT-4o یا Llama 3.1 با حجم غیرقابل وصفی از داده تعلیم دیدهاند تا بتوانند به بهترین شکل ممکن، درخواستهای ما را پاسخ دهند؛ اما اگر نیاز باشد زمانی این اطلاعات از حافظهی مدلها پاک شوند، دردسرها شروع میشود. برای مثال فرض کنید مدل یادگیری ماشین شما بهطور تصادفی با دادههایی شامل اطلاعات بانکی شخصی، آموزش دیده است. چگونه میتوانید بدون اینکه مدل را مجدداً آموزش دهید، این اطلاعات خاص را پاک کنید؟

خوشبختانه حالا محققان در حوزهی جدیدی با نام Machine Unlearning یا «فراموشی ماشین» روی این مشکل کار میکنند. فراموشی یا یادگیریزدایی ماشین حوزهای نوظهور اما حیاتی محسوب میشود که بازیگران مهمی در حال ورود به آن هستند.

در ادامه با ما همراه باشید تا نگاه نزدیکتری به این مفهوم داشته باشیم و ببینیم آیا مدل های زبانی بزرگ واقعاً میتوانند آموختههای خود را فراموش کنند؟

حتی قویترین مدلهای هوش مصنوعی مولد هم از هوش واقعی برخوردار نیستند. شما میتوانید آنها را سیستمهای آماری پیشبینیکنندهای بدانید که قادرند کلمات، تصاویر، گفتار، موسیقی، ویدیو و سایر دادهها را تولید یا تکمیل کنند. این مدلها با تحلیل تعداد زیادی مثال (مانند فیلمها، صداهای ضبطشده، مقالهها و نظیر آن) یاد میگیرند میزان احتمال وقوع دادههای خاص را پیشبینی کنند. آنها الگوها را شناسایی میکنند و کانتکست پیرامون هر داده را در نظر میگیرند.

برای مثال وقتی محتوای ایمیلی به عبارت «…Looking forward» (مشتاقِ…) میرسد، مدلی که برای تکمیل خودکار پیامها آموزشدیده، پیرو الگویی که از ایمیلهای مشابه شناسایی کرده است، عبارت «… to hearing back» (شنیدن پاسخ) را برای ادامهی متن پیشنهاد میدهد. درواقع کاری که مدل انجام میدهد آگاهی نیست، بلکه صرفاً حدسی هوشمندانه بر پایهی آمار و الگوهای مشابه است.

بیشتر مدلها از جمله پرچمدارانی مانند GPT-4o، بر مبنای دادههایی که در وبسایتهای عمومی و مجموعههای داده در سرتاسر وب منتشر شدهاند، آموزش میبینند. اغلب شرکتهایی که از فروش اشتراک چتباتها و ابزارهای AI کسب درآمد دارند، معتقدند جمعآوری داده برای آموزش مدلها «استفادهی منصفانه» محسوب میشود و نیازی به اطلاعرسانی و اعتباردادن به مالکان محتوا و پرداخت کپیرایت ندارد. بااینحال، بسیاری از ناشران و صاحبان سبکهای هنری با این ادعا موافق نیستند و حقوق خود را با شکایات قانونی پیگیری میکنند.

مدلهای هوش مصنوعی در مرحلهی پیشآموزش، از حجم وسیعی از دادهها که اصطلاحاً Corpus نامیده میشود، استفاده میکنند تا برای هر کلمه یا ویژگی، ارزش و وزن خاصی بهدست آورند که نشاندهندهی اهمیت و ارتباط آن ویژگیها در دادههای مختلف است. این دادهها مستقیماً تعیین میکنند که مدل چه چیزی را درک خواهد کرد. پس از مرحلهی پیشآموزش، مدل برای بهبود نتایج پالایش میشود.

در مورد مدلهای مبتنی بر معماری ترنسفورمر مانند ChatGPT، این پالایش غالباً به شکل RLHF (یادگیری تقویتی با بازخورد انسانی) انجام میشود، بدین معنی که انسانها مستقیماً به مدل بازخورد میدهند تا پاسخهای آن را بهبود بخشند.

آموزش مدلهای هوش مصنوعی، به قدرت پردازشی GPUها نیاز دارد که هم پرهزینهاند و هم هر روز کمیابتر میشوند. مدتی پیش The Information هزینههای روزانهی عملیاتی چتجیپیتی را ۷۰۰ هزار دلار برآورد کرده بود.

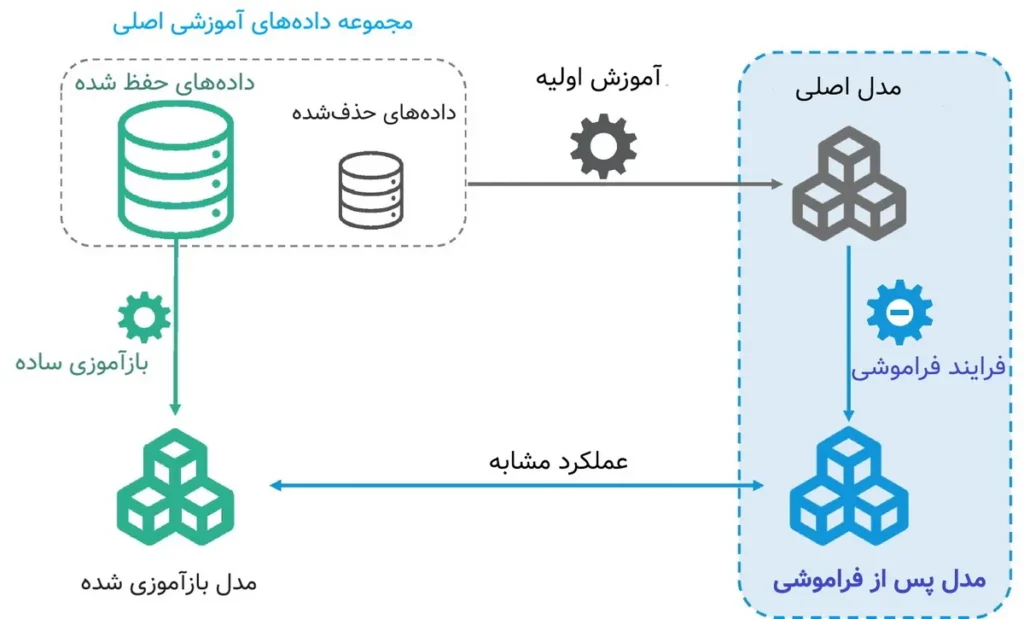

محققان هدف اصلی فراموشی ماشین را حذف «تأثیرات» دادههای آموزشی از یک مدل تعلیمدیده توصیف میکنند. به عبارتی با یادگیریزدایی از یک مدل خاص، باید به رفتاری مشابه با مدل دیگری برسیم که با «همان مجموعه اطلاعات اصلی، منهای برخی اطلاعات نامطلوب» تعلیمدیده باشد.

بااینحال در این تعریف باید به برخی نکات توجه کنیم:

چگونه میتوان اطلاعاتی را که باید فراموش شوند، بهدرستی مشخص کرد؟ آیا همیشه امکان دسترسی به مدلهایی که براساس دادههای واقعی آموزش دیدهاند، وجود دارد؟ آیا همیشه مدلهای بازآموزیشدهی معتبری در اختیار داریم و اگر نه، چگونه واقعاً یادگیریزدایی را ارزیابی کنیم؟

آیا اصولاً میتوانیم یادگیریزدایی را تأیید و کنترل کنیم؟ اگر مدلها صرفاً «تظاهر» به فراموشی کنند، برای نتیجهی امن و مطلوب کافی است؟ در نهایت، فراموشی ماشین چه مواقعی راهحل مفیدی محسوب میشود؟

ایدهی فراموشی مدلهای یادگیری ماشین، از سال ۲۰۱۴ و با مصوبهی «حق فراموششدن» در مادهی ۱۷ قانون GDPR اتحادیه اروپا آغاز شد. در آن زمان مسئله این بود که کاربران بتوانند از ارائهدهندگان خدمات آنلاین بخواهند دادههای مورد نظرشان را از سیستمها حذف کنند؛ اما باید توجه داشته باشیم که «حق فراموششدن» در ابتدا با هدف حذف اطلاعات در سیستمهای منظم و ساختاریافته، مانند دادههای حساب کاربری در سرویسهایی مانند جیمیل، طراحی شده بود و نه برای مدلهای یادگیری عمیق که دادهها را بهصورت پیچیده و درهمآمیخته ذخیره میکنند.

همین پیچیدگی باعث شد که محققان روشهای حذف دادهها و فراموشی ماشین را مورد مطالعه قرار دهند. حالا در سال ۲۰۲۴، انگیزهی فراموشی در مدلها صرفاً به حفظ حریم خصوصی محدود نمیشود. با توسعهی مدلهای بزرگ که براساس مجموعههای دادهی متنوعی شامل محتواهای دارای کپیرایت، مطالب خطرناک یا توهینآمیز آموزش داده شدهاند، نیاز به فراموشی بخشهایی از این دادهها یک ضرورت محسوب میشود.

بهطور کلی، انگیزههای فراموشی ماشین را میتوان به دو دسته تقسیم کرد:

در دنیای ایدئال، شاید میتوانستیم دادهها را بهعنوان اطلاعاتی که به امانت گرفته میشوند در نظر بگیریم. در این صورت فراموشی ماشین با این هدف دنبال میشد که این امانتها را به صاحبانشان بازگرداند. اما به دلیل پیچیدگیهای یادگیری عمیق، دادههای واردشده به مدل بیشتر به «اقلام مصرفشده» شباهت دارند و بازگرداندن چیزی که مصرف شده، چندان آسان نیست. حتی برخی دادهها مثل تاریخچهی چتهای شخصی غیرقابل جایگزینی هستند و بهای آنها به هر فرد بستگی دارد.

برای درک این مفهوم، به مثالی ساده توجه کنید: اگر «باب چیزکیک آلیس را خورد» را معادل «داده» بگیریم، اقدامی نظیر «آلیس ترجیح میدهد باب به او پول بدهد یا چیزی معادلش را برگرداند»، معادل جبران خسارت یا حق مالی مالک داده خواهد بود؛ زیرا امکان بازگرداندن چیزی که باب خورده است یا همان فراموشی ماشین، بسیار غیرمنطقی و دشوار میشود.

در این حالت، احتمالاً خلق جایگزینهایی مانند بازارهای داده که در آن حق مالکان داده بهدرستی پرداخت میشود تا بعدها نیازی به فراموش داده نباشد، بسیار ارزشمند خواهد بود.

این نوع از فراموشی بهمنظور تصحیح اشتباهات و حذف موارد نامطلوب از مدلها استفاده میشود. بهعبارتدیگر، فراموشی میتواند بهعنوان یک سازوکار کاهش ریسک در برابر خطرات هوش مصنوعی عمل کند.

برخلاف لغو دسترسی، در اصلاح مدلها از انعطافپذیری بیشتری برخورداریم، زیرا اصلاح یا ویرایش عمدتاً از مطلوبیت ناشی میشود و ضرورتی قانونی نیست: درست مانند دقت مدل در طبقهبندی تصویر یا سمیبودن متن تولیدشده (البته این موارد هم میتوانند آسیبهای واقعی ایجاد کنند).

در این حالت برای اطمینان از اینکه فراموشی ماشین خوب عمل میکند، به تضمین رسمی نیاز نداریم (گرچه ضمانت برای ما مطلوبیت دارد)؛ همانطور که در حال حاضر کاربران زیادی هستند که با رضایت کامل از مدلهایی استفاده میکنند که «به اندازهی کافی ایمن» تشخیص داده شدهاند.

در نگاه اول فراموشی ماشین بهسادگی با بازآموزی مدل بدون دادههای ناخواسته محقق میشود. تصور کنید کتابخانهی بزرگی دارید و میخواهید تمام کتابهای نویسندهای خاص را از آن حذف کنید. سادهترین راه این است که تمام کتابها را بیرون بریزید و کتابخانه را از نو، بدون کتابهای آن نویسنده مرتب کنید. این راهکار را میتوانیم معادل «بازآموزی کامل» در یادگیری ماشین بدانیم؛ اما محققان به دنبال راهحلهای بهتری هستند؛ زیرا از طرفی بازآموزی غالباً بسیار پرهزینه تمام میشود و از طرف دیگر پیداکردن موارد قابل حذف از دادههای آموزشی کار زیادی میبرد (به پیداکردن تمام اشارات به هری پاتر در یک تریلیون توکن فکر کنید).

تکنیکهای یادگیریزدایی از اساس به دنبال کاهش یا اجتناب از این هزینهی بازآموزی هستند، درحالیکه نتایج یکسان یا مشابه تولید میکنند.

نگاهی کنیم به برخی از روشهای رایج فراموش ماشین که تا به امروز بیشتر مورد توجه محققان بودهاند:

روشهای فراموشی غیردقیق گاهی باعنوان «فراموشی تقریبی» شناخته میشوند، به این معنی که رفتار مدل یادگیریزداییشده، تقریباً به مدل بازآموزیشده شباهت دارد.

در ادامه نگاهی نزدیکتر به هر یک از این روشها خواهیم داشت.

هدف فراموشی دقیق این است که مدل جدید (بعد از حذف دادهها) دقیقاً مثل مدلی عمل کند که از اول بدون آن دادهها آموزشدیده است.

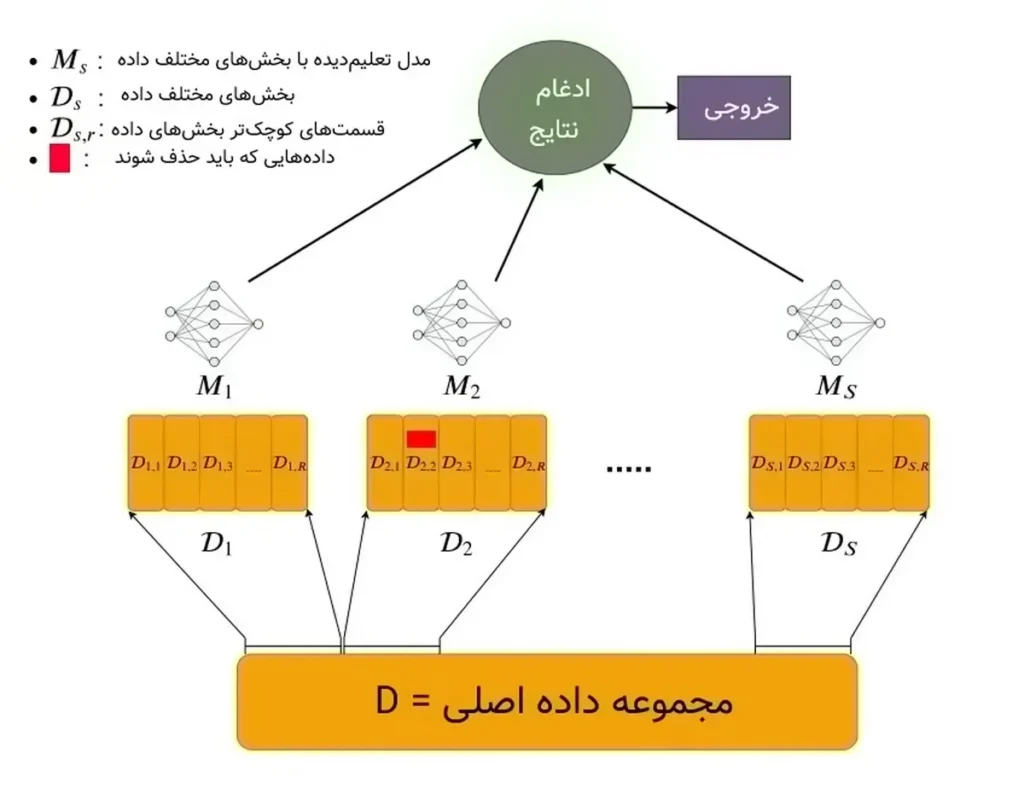

این روش معمولاً با تقسیم مجموعهی داده به بخشهای غیرهمپوشان و آموزش جداگانهی مدل با هر بخش از دادهها انجام میشود. اگر نیاز به فراموشی دادههای خاصی باشد، تنها بخشی از مدل که با دادههای مربوطه تعلیم دیده است، دوباره تحت آموزش قرار میگیرد.

در مثال قبل، فرض کنید کتابخانه را به چند بخش تقسیم کردهایم و برای هر بخش یک کتابدار جداگانه تعیین کردهایم. پس وقتی میخواهیم کتابهای یک نویسنده را حذف کنیم، فقط به کتابدارهایی که به کتابهای موردنظرمان دسترسی دارند خبر میدهیم.

اگر مجموعهدادهها را به N بخش تقسیم کرده باشیم، هزینهی محاسباتی روش فراموشی دقیق یعنی آموزش مجدد مدل بر اساس تغییر دادههای یک بخش، معادل یک Nام آموزش کل مدل خواهد بود. در زمان استنتاج هم همهی مدلها با هم ترکیب میشوند.

مهمترین مزیت فراموشی دقیق این است که ساختار ماژولار آن به ما اطمینان میدهد که دادههای حذف شده واقعاً تأثیری در نتایج ندارند و خود ساختار الگوریتم، درستی کار را ثابت میکند. به عبارتی چالش ارزیابی مدلها پس از فراموشی تا حدودی حل میشود. از طرف دیگر بهدلیل شفافیت پروسهها، بهتر میفهمیم که هر داده چه تأثیری در عملکرد مدل دارد.

اگر حضور داشتن یا نداشتن یک داده در مدل، تغییر خاصی در رفتار آن ایجاد نکند، میتوانیم استنباط کنیم که نیازی به یادگیریزدایی مدل در خصوص دادهی مربوطه نخواهیم داشت.

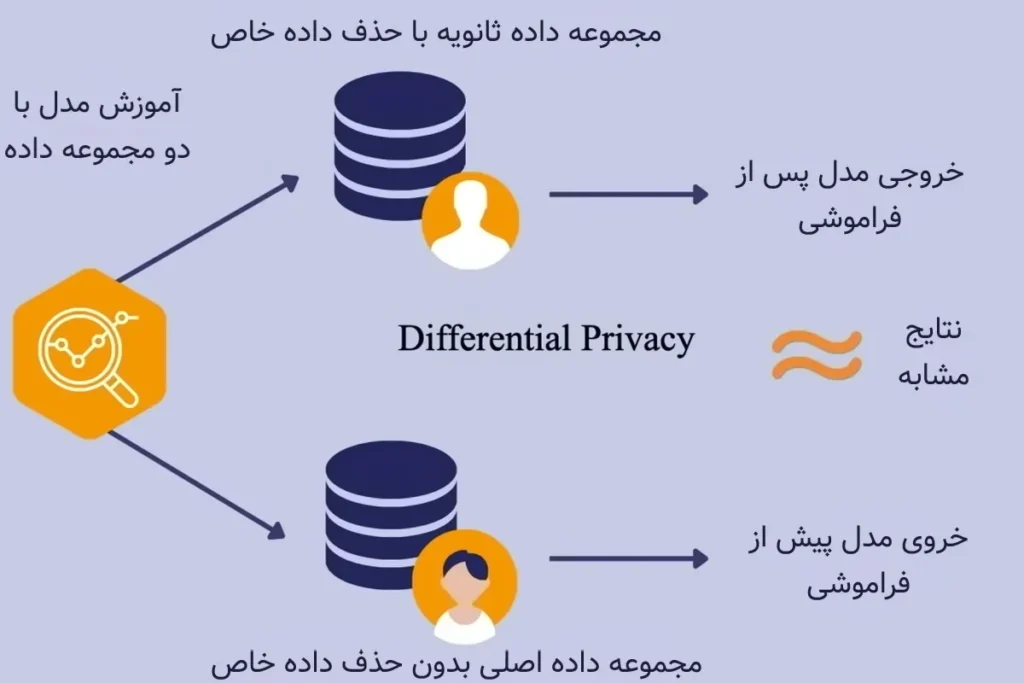

این ایده، مبنای اصلی روشی است که Differential Privacy (حریم خصوصی تفاضلی) یا بهاختصار DP نام دارد: بهعبارتدیگر در روش حریم خصوصی تفاضلی حساسیت مدل به تمام دادهها بهقدری کم میشود که حذف یک داده یا اضافهکردنش، تغییر بزرگی در نتایج ایجاد نمیکند.

در این تکنیک تفاوت بین مدل بازآموزیشده (بدون دادهی مورد نظر) و مدل اولیه به حداقل میرسد و توزیع نموداری نزدیکی را از هر دو آنها دریافت میکند.

فرض کنید کسی میخواهد دادهی شخصی او از مدل پاک شود. اگر روش حریم شخصی درست پیاده شده باشد، وقتی آن داده را از مدل حذف کنیم، مدل همچنان همان رفتار قبلی را نشان میدهد؛ انگار هیچوقت دادهی مذکور را یاد نگرفته است. بهاینترتیب اصولاً نیازی به «فراموشی» خاصی نیست چون خود مدل طوری طراحی شده که اثر آن داده خاص را بهسختی بروز دهد.

یکی از روشهای معمول اجرای DP، اضافهکردن نویز به دادهها است: هنگامیکه میخواهیم مدل را تعلیم دهیم، به دادهها کمی نویز اضافه میکنیم تا اثر هر دادهی خاص را کمرنگتر کنیم.

در مثالی ساده فرض کنید وقتی مدل دارد چیزی را از جملهای یاد میگیرد، چند کلمهی بیربط و اضافه نیز وارد جمله شود. اگر بعدها بخواهیم آن جمله را حذف کنیم، ازآنجاکه نویز تأثیر کلی دادهها را کاهش داده، مدل تغییر چندانی حس نمیکند.

از نظر فنی در این روش ابتدا برای کاهش تأثیر هر داده، بزرگی گرادیانها را محدود میکنیم. بهاینترتیب مدل نمیتواند بهصورت ناگهانی از یک دادهی خاص خیلی چیز یاد بگیرد و تأثیرپذیری مشخصی از دادهها خواهد داشت. سپس کمی نویز به دادهها اضافه میکنیم تا اثر دقیق هر داده پنهان شود و حتی اگر دادهای حذف شود، اثرش در نتیجهی نهایی مدل به چشم نیاید.

معیار DP با دو عدد اپسیلون (ε) و دلتا (δ) شناخته میشود. این دو عدد به ما کمک میکنند بفهمیم حریم خصوصی مدل چقدر قوی است:

درمجموع کوچکتر بودن ε و δ یعنی مدل حریم خصوصی قویتری دارد و اثر دادههای خاص را به حداقل میرساند.

در بخشهای بعد توضیح میدهیم چرا افزایش نویز به کاهش کارایی مدل منتهی میشود، اما فعلاً این مسئله را در نظر بگیرید که استفاده از نویز مثل این است که برای پیدانکردن شخصی خاص در میان جمعیت، چهرهی همه را با ماسک بپوشانیم. شاید نهایتاً مدل ما شخص مورد نظر را شناسایی نکند، ولی همزمان در تشخیص سایر دادهها نیز دچار مشکل میشود.

در این روش، فراموشی ماشین با ایجاد تغییرات کوچک در مدل از طریق گامهای «افزایشی» انجام میشود. تکنیکهای تجربی بیشتر بر پایهی آزمونوخطا پیش میروند و محققان با تنظیم دقیق پارامترها تلاش میکنند که مدل رفتار دلخواهی در برابر دادههای نامطلوب نشان دهد.

نکتهی اصلی این است که فقط وقتی فضای نمونهها را میشناسیم، میتوانیم از این روش استفاده کنیم.

به بیان ساده چند قدم حساب شده برمیداریم تا رفتار مدل اصلی را بهگونهای تغییر دهیم که انگار از اول با دادههای جدید آموزش دیده است. مدل بهطور محدود و با تنظیمات خاصی دوباره آموزش داده میشود تا رفتار آن در جهت فراموشکردن برخی دادهها تغییر کند.

برای مثال در رقابت NeurIPS سال ۲۰۲۳ هدف این بود که با استفاده از یک الگوریتم یادگیریزدایی، مدلی تولید شود که دیگر به دادههای خاصی (مثلاً عکسهای چهره) دسترسی نداشته باشد و رفتارش با مدل مرجع که تنها با دادههای باقیمانده آموزش دیده است، شباهت داشته باشد.

شرکتکنندگان ۳ ورودی اصلی دریافت میکردند:

همچنین مدلهایی مخفی وجود داشت که صرفاً با دادههای «نگهداشتنی» آموزش دیده بودند. شرکتکنندهها باید الگوریتمی مینوشتند که ۵۱۲ مدل جدید و یادگیریزداییشده مختلف با عملکردی مشابه مدلهای مخفی تولید میکرد.

در نهایت مشخص شد برندگان مسابقه از ترکیب چند روش استفاده کردهاند:

دلیل محبوبیت روشهای تجربی، این است که سادهتر و سریعتر اجرا میشوند و درعینحال تأثیر خوبی روی مدل دارند. بهعلاوه نتایج کار هم بهراحتی دیده میشود. برعکس در روشهای نظری که از محاسبات پیچیده استفاده میکنند، در عمل کُند و سخت اجرا میشوند و به منابع زیادی نیز نیاز دارند.

اما یکی از چالشهای اصلی روش تجربی این است که نمیدانیم در حالت ایدئال، یک مدل بعد از فراموشکردن چه رفتاری با دادههای جدید از خود نشان میدهد؛ مثلاً آیا باید تصاویری را که حذف شدهاند، بهصورت تصادفی و بدون اطمینان دستهبندی کند یا خیر.

این عدم قطعیت در رفتار مدل به دلیل وجود شرایط و سناریوهای مختلف میتواند به تفاوتهایی در خروجی مدل منجر شود و پیشبینی دقیق اثرات آن را دشوار کند. در نتیجه اثبات کارایی مدل جدید و شباهت آن به مدل اصلی زیر سؤال میرود، چرا که مدل پس از حذف دادهها میتواند نتایج و خروجیهای متنوعی ایجاد کند.

زمانی که دادههایی که باید فراموش شوند بهصورت دقیق مشخص نیستند و تنها به شکل مفاهیم یا دانشی کلی در مدل وجود دارند، از این روش تجربی استفاده میشود.

برای مثال فرض کنید میخواهیم یک مدل مفهوم «بایدن رئیسجمهور آمریکا است» را فراموش کند. اما مفهوم واقعی این جمله در قالبهای مختلفی در دادهها موجود است، مثل مقالهها، گفتگوهای عمومی، ویدیوها، پستهای وبلاگ یا متنهای خبری. بنابراین تنها با حذف چند نمونهی خاص به هدف نمیرسیم.

معمولاً اصطلاحاتی مانند «ویرایش مدل»، «ویرایش مفهوم»، «جراحی مدل» و «یادگیریزدایی دانش» به این تکنیک فراموشی ماشین اشاره دارند.

اما وقتی درخواست فراموشکردن تا این حد نامشخص است، باید روی موضوعاتی مثل دامنهی ویرایش و چگونگی روابط اطلاعات تمرکز کنیم.

گاهی اوقات چند مثال دریافت میکنیم که با توجه به آنها میفهمیم چه چیزی از مدل باید یادگیریزدایی شود. اما این اطلاعات در مجموعهدادههای آموزشی به شکلهای مختلفی و با پیامدهای متفاوتی ظاهر میشود. پس حتی اگر بتوانیم دقیقاً همان مثالها را پاک کنیم، کافی نیست.

فضای نمونهی ناشناخته در فرمهای زیر بهتر احساس میشود:

در این مواقع ازآنجاکه نمیتوانیم همهی دادههای مربوط به یک مفهوم خاص را دقیقاً مشخص کنیم، فرایند یادگیریزدایی بهصورت «تجربی» انجام میشود. یعنی از راهکارهایی استفاده میشود که مدل به طور تقریبی رفتار خود را تغییر دهد، بدون اینکه تضمینی وجود داشته باشد که تمام اطلاعات موردنظر پاک شده باشند.

نکتهای که شاید برایتان جالب باشد: وقتی بهصورت تجربی اطلاعاتی را از مدل پاک میکنیم، خود این یادگیریزدایی هم میتواند یادگیریزدایی شود.

در عمل فراموشی تجربی با استفاده از تغییرات کوچک و مداوم در مدل انجام میشود:

تحقیقات نشان میدهد که مدلهای زبانی بزرگ قدرتمند و دستورپذیر مانند GPT-4، بهقدر کافی هوشمند هستند که بتوانند فراموشی را «تظاهر کنند». بهعبارتی میتوان پیامهایی طراحی کرد که رفتار مدل را درخصوص فراموشی اطلاعات موردنظر، به حد کافی ایمن کند.

موضوع جالب درمورد این روش این است که اصولاً از گرادیان یا جهتدهی توجه مدل استفاده نمیکند و درعینحال نتایج مطلوبی تولید میکند. تا به امروز کارشناسان از ۳ راهکار خروجی نسبتاً خوبی دریافت کردهاند:

۱) درخواست صریح از مدل برای تظاهرکردن: میتوانیم در پیام سیستمی از مدل بخواهیم که وانمود کند هری پاتر را نمیشناسد. این روش برای اطلاعات عمومی و رایجی که در دادههای آموزشی بهخوبی گنجانده شده، بهتر جواب میدهد. زیرا مدل باید بهخوبی از اطلاعات مربوطه مطلع باشد تا بتواند فراموشی آنها را تظاهر کند.

اما اگر بخواهیم مدل چیزی مثل آدرس فرد ناشناسی را فراموش کند (که شاید در دادههای آموزشی وجود داشته) مسئله پیچیدهتر میشود. درواقع این کار به اثر «استرایسند» شباهت دارد که اگر بیشازحد روی فراموشی چیزی تمرکز کنیم، ممکن است ناخواسته آن را فاش کنیم.

۲) روش نمونه محور: در این حالت با ارائهی مثالهایی خاص به مدل، از او میخواهیم اطلاعات نادرست را بهعنوان حقیقت بپذیرد. مثلاً اگر میخواهیم مدل این واقعیت را که «پاریس پایتخت فرانسه است» فراموش کند، در ورودی مدل با چندین مثال این جمله را با اطلاعاتی اشتباه وارد میکنیم.

این رویکرد زمانی کارآمدتر است که دادههای فراموشی، دقیق و محدود باشند. اما در شرایطی که با فرایندهای پیچیدهتری مثل «حذف رفتارهای سمی و ناخواسته» سروکار داریم، احتمالاً پاسخ مطلوبی دریافت نمیکنیم، زیرا تعداد خروجیهای احتمالی بسیار زیاد هستند.

۳) سیستم چندمدلی: در این سیستم تنها یک رابط برای ورودی و خروجی مدل کلی فراهم میشود و مدلهای مختلفی نیز برای شبیهسازی بخشهای مختلف بهکار میروند: مثلاً یک مدل به سؤالات کلی پاسخ میدهد، مدل دیگری نقش تکمیل جملات را به عهده میگیرد و نظیر آن.

همچنین مدل هماهنگکننده، تعیین میکند که کدام مدل در پاسخدهی به سؤال کاربر مورد استفاده قرار بگیرد. نهایتاً یک مدل جمعبندی کننده خروجی نهایی را بر اساس رفتار فراموشی موردنظر تدوین و حتی فیلترهایی را نیز روی آن اعمال میکند.

انتقادی که به تمامی این روشها وارد میشود، این است که مدرک یا تضمینی برای فراموشی به ما نمیدهند. در مقابل، برخی کارشناسان استدلال میکنند که خود انسانها هم واقعاً چیزی را فراموش نمیکنند، بلکه عموماً تصمیم میگیرند از دانستههای قبلی خود در موقعیتهای خاص استفاده نکنند. پس شاید بهجای اینکه از هوش مصنوعی انتظار داشته باشیم چیزی را کاملاً فراموش کند، باید به آن یاد بدهیم چه زمانی، چگونه دانش خود را به کار بگیرد.

یادگیریزدایی ماشین با حذف دادههای خاص بهویژه در مدلهای بزرگ و پیچیده، بدون پردازشهای سنگین و چندباره امکانپذیر نیست و هزینههای محاسباتی و زمانی بالایی را به همراه دارد. در مدلهای هوش مصنوعی GPT-4o و Bert که با میلیاردها پارامتر تعلیم دیدهاند، فرایند حذف برخی دادهها به اندازهی آموزش مجدد کل مدل، وقت و تلاش خواهد برد.

بهعلاوه نیاز به منابع پردازشی بسیار قوی مانند مجموعهی جیپییوها و پردازندههای تنسور، بهاحتمال زیاد شرکتهای کوچکتر را از پیادهسازی تکنیکهای فراموشی منصرف میکند.

در مدلهای یادگیری عمیق، دادههای آموزشی بهصورت پیچیدهای در وزنها و پارامترهای مدل گنجانده میشوند. حتی اگر بخشی از دادهها حذف شوند، ممکن است اثری از آنها به شکل غیرمستقیم همچنان در مدل باقی بماند.

بهعنوان مثال، یک مدل زبانی که با دادههای جانبدارانه آموزشدیده، حتی پس از حذف این دادهها ممکن است برخی الگوهای سوگیرانه را همچنان حفظ کند.

از طرف دیگر روشهای تقریبی تضمینی برای حذف کامل دادهها ارائه نمیدهند. در شرایطی که رگولاتورها فراموشی را امری «حیاتی» بدانند، این مشکل محدودیتی جدی محسوب میشود و اعتبار مدل را زیر سؤال میبرد.

مهمترین چالشی که در حوزهی یادگیریزدایی از مدلها به چشم میخورد، این است که غالباً حذف دادهها به کاهش دقت و کارایی مدل منجر میشود.

تحقیقات نشان میدهد که در برخی موارد، حذف دادههای خاص میتواند مدل را حتی در انجام وظایف ساده خود نیز ناتوان کند. بهعنوان مثال در یک مدل شناسایی تصویر، حذف تصاویر خاصی از افراد میتواند باعث کاهش دقت کلی مدل در شناسایی آن دسته از تصاویر شود.

هرچه تنوع و گستردگی اطلاعات ورودی بیشتر باشد، احتمال اینکه بعد از حذف برخی دادهها تعادل مدل از بین برود هم بیشتر میشود.

همچنین در برخی از تکنیکهای فراموشی ماشین، اضافهکردن نویز به دادهها یا گرادیانها باعث میشود حساسیت مدل به دادههای خاص کاهش یابد، اما روی دقت کلی مدل نیز اثر منفی خواهد داشت.

محققان بهدنبال یافتن راهحلی برای برقراری تعادل بین «حذف یا تغییر دادهها» و «صحت و دقت پاسخگویی» مدلها هستند، زیرا در حوزههایی مانند تشخیص پزشکی یا تحلیل دادههای حیاتی، خروجیهایی که تحت نویز به دست میآیند، پیامدهای غیرقابل بازگشتی به دنبال دارند.

ارزیابی میزان موفقیت روشهای آنلرنینگ و بررسی اینکه آیا مدل واقعاً دادههای خاصی را فراموش کرده یا خیر، به دلیل پیچیدگیهای ساختاری و وابستگیهای داخلی مدلها، بسیار دشوار است.

ابزارهای ارزیابی فعلی عمدتاً میزان دقت و عملکرد کلی مدل پس از حذف دادهها را میسنجند، ولی توانایی تشخیص ردپاهای کوچک و غیرمستقیم دادهها در مدل را ندارند. به همین دلیل محققان توسعهی معیارهای جدیدی که بهطور دقیق وابستگی مدلهای تغییریافته به دادههای حذف شده را ارزیابی کند، ضروری میدانند.

مطالعات جدید محققان دانشگاه واشنگتن، پرینستون، شیکاگو، USC و شرکت گوگل نشان میدهد محبوبترین تکنیکهای فراموشی امروزی، هریک بهنوعی قدرت مدلها را کاهش میدهند؛ تا جایی که گاهی بعد از اعمال تغییرات، مدلها دیگر قابل استفاده نیستند.

ویجیا شی، یکی از محققان حوزهی آنلرنینگ و دانشجوی دکترای علوم کامپیوتر دانشگاه واشنگتن، میگوید:

ارزیابی ما نشان میدهد که روشهای یادگیریزدایی فعلی هنوز برای استفادهی معنادار یا پیادهسازی در سناریوهای دنیای واقعی آماده نیستند. در حال حاضر هیچ روش کارآمدی وجود ندارد که به یک مدل اجازه دهد دادههای خاصی را فراموش کند، بدون اینکه کارایی آن بهطرز چشمگیری کاهش یابد.

شی و همکارانش برای بررسی اثربخشی این الگوریتمهای فراموشی معیار سنجشی را طراحی و هشت الگوریتم متنباز مختلف را برای آزمایش انتخاب کردند.

هدف این معیار که MUSE (ارزیابی ششگانهی یادگیریزدایی ماشین) نام دارد، این بود که توانایی مدل را با دو معیار اصلی بسنجد: وجودنداشتن دادههای حذف شده در پاسخها و همچنین فراموشی دانش کلی در مورد یک موضوع، یا هرگونه شواهدی که نشان دهد مدل در اصل با این دادهها تعلیم دیده است.

دریافت امتیاز خوب در این تحقیقات، مستلزم این بود که مدل دو چیز را فراموش کند: مجموعه کتابهای هری پاتر و مقالات خبری.

برای مثال به این جمله از کتاب هریپاتر و تالار اسرار توجه کنید: «خاله پتونیا درحالیکه به پسرش نگاه میکرد، گفت در ماهیتابه غذای بیشتری وجود دارد.» محققان برای درک موفقیت الگوریتمها، مدل جدید را به چندین شیوه محک زدند:

نتایج تحقیقات نشان میداد الگوریتمهای آنلرنینگ واقعاً باعث میشوند مدلها اطلاعات خاصی را فراموش کنند، اما درعینحال به قابلیتهای پاسخگویی به سؤالات عمومی نیز آسیب میزنند. شی توضیح میدهد:

طراحی روشهای فراموشی ماشین میتواند چالشبرانگیز باشد، زیرا اطلاعات و دانش پیرامون موضوعات، بهطرز پیچیدهای درون مدل درهمتنیده شدهاند. مثلاً یک مدل احتمالاً هم با محتوای دارای حق نشر «کتابهای رسمی هری پاتر» و هم با محتوای آزاد «ویکی هری پاتر» تعلیمدیده و وقتی روشهای آنلرنینگ موجود تلاش میکنند دادههای کتابهای دارای کپیرایت هری پاتر را حذف کنند، روی اطلاعات مدل درباره ویکی هری پاتر نیز تأثیر قابل توجهی میگذارند.

با گسترش مدلهای یادگیری عمیق و استفادهی روزافزون از دادههای حساس و دارای کپیرایت، نیاز به روشهایی برای حذف یا تعدیل این اطلاعات بیشازپیش احساس میشود. اگرچه راهکارهای فعلی آنلرنینگ هنوز به بلوغ کامل نرسیدهاند و با چالشهای فنی و قانونی زیادی روبهرو هستند، اما تلاشهای مداومی برای بهبود و توسعهی این حوزه در جریان است.

همانطور که فناوریهای یادگیری ماشینی به تکامل خود ادامه میدهند، میتوان انتظار داشت که روشهای جدید و پیشرفتهتری برای مدیریت اطلاعات و فراموشی دادهها طراحی شوند.

به قلم : سرکار خانم پویش پورمحمد

منبع : زومیت

گروه کاردُرست از سال 1400 فعالیت خود را در زمینه طراحی، ساخت و توسعه نرم افزار و سخت افزارهای نوین با توجه به استانداردها و متدولوژیهای روز دنیا و مدنظر قرار دادن ارزشها و باورهای حرفهای و نیز مطالعات کیفی و کمی در زمینه سیستمهای نوین مبتنی بر هوش مصنوعی، به منظور طراحی و توسعه سیستمهای نوین بر بستر شبکههای عصبی و یادگیری ماشین، آغاز نمود.

گروه فنی مهندسی کاردُرست با طراحی چندین پروژه در زمینههای رباتیک، برنامهنویسی، مکانیک و همچنین پروژههای مبتنی بر هوش مصنوعی با بهرهگیری از بروزترین تکنولوژی و متدهای روز دنیا با افتخار در کنار شماست.

کلیه حقوق مادی و معنوی برای این سایت محفوظ می باشد و هرگونه کپی برداری شامل پیگرد قانونی می باشد.